W wysoce konkurencyjnym sektorze finansowym i przy nieustannie ewoluujących wymaganiach rynku hiperpersonalizacja stała się koniecznością, aby oferować produkty dopasowane do indywidualnych potrzeb. Dostosowanie usług bankowych do preferencji odbiorców i ulepszanie ich podróży klienta wymaga jednak podjęcia proaktywnych działań. Realizacja tych zadań wymagać będzie użycia odpowiednich narzędzi. Wybór najlepszego oprogramowania staje się wyzwaniem ze względu na mnogość rozwiązań w dynamicznie rozwijającym się krajobrazie technologicznym.

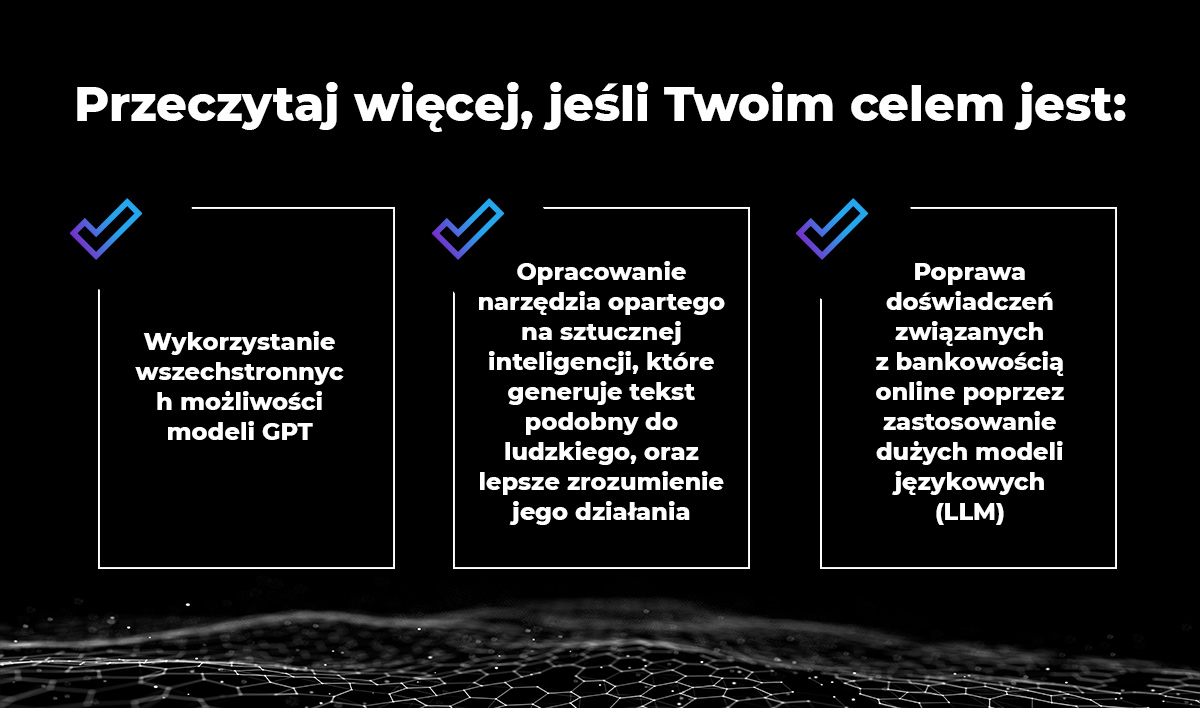

Szeroki wachlarz narzędzi wykorzystujących możliwości sztucznej inteligencji, prezentowanych podczas wydarzeń branżowych i omawianych w publikacjach biznesowych, może przyprawić o zawrót głowy. Dlatego, aby sprawniej poruszać się w złożonym świecie technologii, postanowiliśmy przybliżyć wiedzę na temat uczenia maszynowego (ang. machine learning, ML) i przetwarzania języka naturalnego (ang. natural language processing, NLP). Chcemy pomóc czytelnikom w wyborze najlepszego rozwiązania dla ich firm oraz ułatwić efektywne wykorzystanie danych klientów bankowych.

Szczegółowe zaprezentowanie głównych korzyści, licznych zastosowań, przykładowych scenariuszy biznesowych, backgroundu technologicznego i krótkiego rysu historycznego może pomóc w ocenie, czy konkretne rozwiązanie odpowiada na aktualne potrzeby Twojej organizacji. Przyjrzyjmy się możliwościom zaawansowanych modeli uczenia maszynowego i przekonajmy się, dlaczego hiperpersonalizacja, bazująca na danych behawioralnych przetwarzanych w czasie rzeczywistym oraz nowatorskich algorytmach, jest ważnym krokiem w rozwoju branży finansowej.

Reprezentacja danych klientów bankowych

Każda instytucja finansowa przechowuje ogromne ilości nieustrukturyzowanych danych pochodzących z różnych źródeł, a ich właściwe wykorzystanie może pomóc w uzyskaniu przewagi konkurencyjnej. Wraz ze wzrostem wolumenu danych, wzrasta również ich złożoność, co tworzy zapotrzebowanie na rozwiązania do efektywnego przechowywania i przetwarzania tych danych. Uczenie maszynowe odgrywa kluczową rolę w pogłębianiu naszej wiedzy o cechach, zachowaniach i preferencjach klientów.

Aby prawidłowo przedstawić złożone dane bankowe w sposób umożliwiający ich wykorzystanie przez algorytmy sztucznej inteligencji, konieczne jest zastosowanie wektorowej reprezentacji danych. W takich przypadkach znaczącą rolę odgrywają wektorowe bazy danych. Dzięki lepszej reprezentacji danych klientów łatwiej będzie podejmować strategiczne decyzje dotyczące rozwoju produktów bankowych i segmentacji odbiorców.

Wiedza, czym są wektorowe bazy danych, jak działają i jak przechowują dane, jest cenna nie tylko dla analityków i inżynierów ML, ale również dla wszystkich zainteresowanych wydobyciem wartościowych informacji z tych danych. W naszym e-booku koncentrujemy się na nowoczesnym podejściu do reprezentacji danych klientów bankowych.

Maksymalizacja wartości danych transakcyjnych

Dane transakcyjne są jednym z najcenniejszych, lecz często niedocenianym źródłem informacji o klientach. Wraz z rozwojem organizacji danych przybywa, co stwarza wyzwanie – dane są zbierane, ale nie są odpowiednio przetwarzane w procesach biznesowych, co sprawia, że ich potencjał nie jest w pełni wykorzystywany.

Nadal podstawowym narzędziem stosowanym do analizy transakcji jest analiza statyczna, która szczegółowo bada różne aspekty transakcji takie jak jej rodzaj, kwota, odbiorca, opis i data.

W trakcie analizy danych transakcyjnych pojawia się jednak trudność z automatycznym interpretowaniem kluczowych atrybutów, takich jak nazwa odbiorcy czy opis, które ujawniają prawdziwy cel transakcji dokonywanej przez klienta. Aby maksymalnie wykorzystać potencjał danych transakcyjnych, należy uwzględnić dodatkowe atrybuty, używając do tego modeli uczenia maszynowego. Niniejszy e-book dostarcza wiedzy na temat technicznych aspektów wydobywania pełnej wartości z danych transakcyjnych. Pobierz naszą publikację i przekonaj się, że oferują one cenny wgląd w preferencje klientów, umożliwiając przewidywanie zachowań oraz identyfikowanie trendów rynkowych.

Przeciwdziałanie degradacji modeli ML – wykrywanie dryfu koncepcji i dryfu danych

Badania przeprowadzone przez badaczy z MIT, Harvardu, Uniwersytetu w Monterrey i Cambridge wykazały, że 91% modeli uczenia maszynowego wraz z upływem czasu ulega degradacji. To jasno pokazuje, że zaprojektowanie modelu uczenia maszynowego to jedynie pierwszy krok. Po wdrożeniu w środowisku produkcyjnym konieczne staje się stałe monitorowanie jego niezawodności.

Dryf danych i dryf koncepcji to główne czynniki, które należy wziąć pod uwagę, chcąc zapewnić długoterminową dokładność modeli uczenia maszynowego. Dryf danych, rozumiany jako zmiany we wzorcach i relacjach danych wejściowych, których model ML nauczył się podczas treningu, z biegiem czasu może powodować spadek wydajności modeli produkcyjnych. Oznacza to, że model ML może nadal działać bez zarzutu, bazując na statycznych danych treningowych, jednak wyuczone wzorce staną się przestarzałe w nowej rzeczywistości.

Z drugiej strony, dryf koncepcji definiowany jest jako zmiana w relacji między danymi wejściowymi a celem wraz z upływem czasu. Modele trenowane na danych historycznych mogą tracić dokładność z powodu zmieniających się korelacji między danymi wejściowymi a wyjściowymi. Zrozumienie dryfu koncepcji i dryfu danych ma kluczowe znaczenie dla wykrywania i łagodzenia skutków tych zjawisk. Nasz kompleksowy e-book przybliża ich przyczyny i przedstawia kroki, które należy podjąć, aby im zapobiec.

NLP i modele GPT zmieniają krajobraz sektora finansowego

Wstępnie przeszkolone transformatory generatywne (ang. generative pre-trained transformers, GPT) zdominowały debatę biznesową i technologiczną. To całkowicie zrozumiałe – w końcu oferują one niezrównane możliwości w zakresie generowania tekstu, który wiernie odzwierciedla ludzką mowę. Modele GPT są szeroko stosowane w bankowości i finansach, automatyzując codzienne zadania działów wsparcia oraz zapewniając klientom szybszą, spersonalizowaną pomoc.

Aby w pełni zrozumieć potencjał NLP, warto zrobić krok wstecz i zapoznać się z jego pasjonującą historią, która doprowadziła do dzisiejszych osiągnięć technologicznych. Śledząc kolejne etapy rozwoju dużych modeli językowych (ang. large language models, LLMs), zyskasz wgląd w ewoluującą rolę i cele inżynierów NLP, co uwydatnia dynamiczny charakter tej dziedziny.

W naszym najnowszym e-booku analizujemy, jak duże modele językowe zmieniły podejście do NLP, prowadząc do rozwoju takich narzędzi jak ChatGPT, Gemini i GitHub Copilot. Znajdziesz w nim również szczegółowy opis, jak modele GPT działają w praktyce.

Podziękowania należą się całemu zespołowi FTS Phoenix w Ailleron, a w szczególności autorom powyższych e-booków: Miłoszowi Hańczykowi, Izabeli Czech, Łukaszowi Miętce, Miłoszowi Zemankowi za pogłębioną analizę i chęć dzielenia się ekspercką wiedzą oraz Jakubowi Porzyckiemu, Machine Learning Team Leader, za mentoring i bieżące wsparcie.

Kluczowe wnioski:

- Cel hiperpersonalizacji: W nowoczesnym sektorze finansowym, hiperpersonalizacji jest kluczową strategią utrzymania konkurencyjności. Obejmuje ona wykorzystanie zaawansowanego uczenia maszynowego (ML) i danych behawioralnych w czasie rzeczywistym w celu dostosowania produktów bankowych i usprawnienia podróży klienta.

- Wektorowe bazy danych do reprezentacji danych: Aby ogromne ilości złożonych i nieustrukturyzowanych danych bankowych były użyteczne dla algorytmów sztucznej inteligencji, muszą one być odpowiednio ustrukturyzowane. Wektorowe bazy danych są kluczową technologią, umożliwiającą skuteczniejszą segmentację klientów i podejmowanie strategicznych decyzji opartych na danych.

- Uwolnienie wartości z danych transakcyjnych: Dane transakcyjne są bogatym źródłem informacji o klientach, ale ich pełny potencjał jest często pomijany przez analizę statyczną. Modele uczenia maszynowego są potrzebne do interpretacji subtelnych atrybutów (takich jak opisy transakcji) w celu zrozumienia intencji klientów, przewidywania zachowań i rozpoznawania trendów rynkowych.

- Przeciwdziałanie degradacji modeli ML: Modele uczenia maszynowego nie są statyczne; ich wydajność pogarsza się z czasem. Jest to spowodowane przez dryf danych (zmiany we wzorcach danych wejściowych) i dryf koncepcji (zmiany w relacji między danymi wejściowymi i wyjściowymi). Ciągłe monitorowanie jest niezbędne do utrzymania długoterminowej dokładności i niezawodności tych modeli.

- Wpływ generatywnej sztucznej inteligencji i NLP: Technologie takie jak Wstępnie wytrenowane transformatory generatywne (GPT) i inne duże modele językowe (LLM) przekształcają finanse. Umożliwiają one automatyzację codziennych zadań wsparcia i zapewniają szybszą, wysoce spersonalizowaną obsługę klienta dzięki zaawansowanym możliwościom języka naturalnego.

English

English Deutsch

Deutsch